|

个人信息Personal Information

教师英文名称:Wei-Qiang Zhang

教师拼音名称:Zhang Wei Qiang

电子邮箱:

办公地点:电子工程馆5-111

联系方式:010-62781847

学位:博士学位

毕业院校:清华大学

学科:信号与信息处理

AI创作灵魂Rap,Transformer跨界说唱音乐

点击次数:

DeepRapper是一个基于深度学习的说唱生成模型,该项工作以长文发表于ACL 2021。DeepRapper能自动生成带有押韵和节奏的Rap歌词,有潜力帮助到说唱歌手的歌词创作中,激发歌手的创作灵感,提升创作效率。未来,该团队希望可以进一步结合Rap的歌唱模型打造完全端到端的说唱Rap内容生成,更好的赋能说唱歌手的内容创作。

L. Xue, K. Song, D. Wu, X. Tan, N. L. Zhang, T. Qin, W.-Q. Zhang, and T.-Y. Liu, “DeepRapper: Neural rap generation with rhyme and rhythm modeling,” in Proc. ACL, 2021, pp. 69-81. doi: 10.18653/v1/2021.acl-long.6.

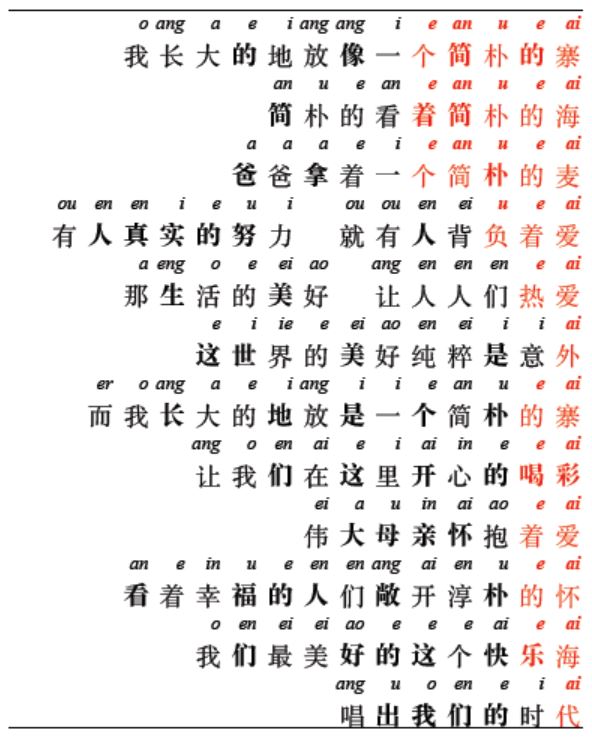

给你一段Rap,你能看出这是AI创作的吗?

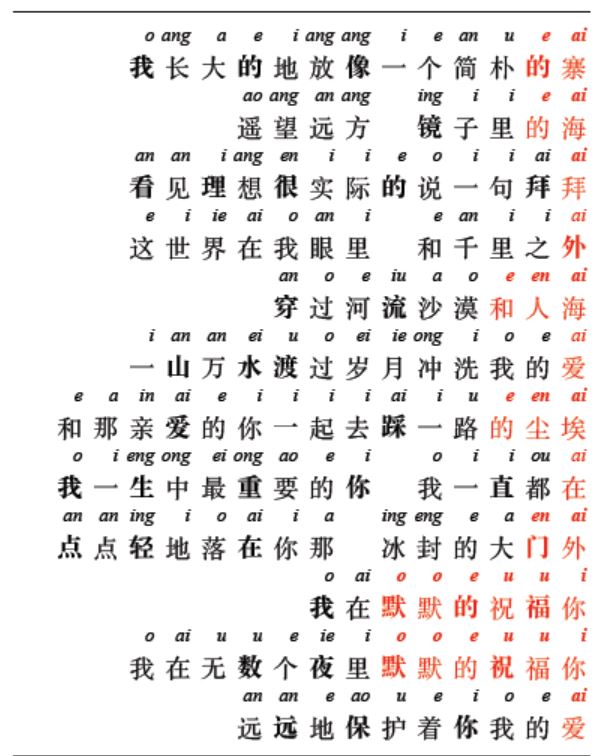

怎么样?押韵、节奏、流畅度,都不亚于人类水平吧!节拍变慢一点,再来感受一首:

在这篇论文中,研究者提出了一个基于 Transformer 的 Rap 生成系统“DeepRapper”,该系统可以同时模拟Rap的韵律和节奏。

由于没有现成可用的节奏对齐的Rap数据集,为了构建这个系统,研究者设计了一个数据挖掘pipeline,并收集了一个大规模的Rap数据集进行韵律建模。

一开始,研究者先从网上抓取了许多包含歌词和音频的说唱歌曲,并对每一首抓取的说唱歌曲进行一系列数据预处理步骤。为了更好地建模,研究者以自回归的方式从右到左生成每一句Rap,这样就可以很容易地识别出一个句子的最后几个单词 (即反向句子的第一个单词) 来押韵。

此外,为了进一步提高Rap的押韵质量,研究者在语言模型中加入了一些押韵表征,并在推理过程中通过押韵约束来提高生成的Rap中的N-gram韵律。

研究者使用一个特殊的标记[BEAT]来表示有节奏的节拍,并将其插入到相应的词之前的歌词中。通过这种方式,可以在训练和生成方面按照歌词的顺序来模拟节拍。

受到预训练语言模型的成功启发,研究者将预训练纳入系统。为了获得大规模的预训练数据,研究者还使用了数据挖掘pipeline收集了另外两个数据集:

(1)节拍对齐的非说唱歌曲,它可以比说唱数据集更大,因为非说唱歌曲比说唱歌曲更通用;

(2)纯歌词,同样比非说唱歌曲数据集更大。

在预训练阶段,研究者基于上述两个数据集对DeepRapper模型进行了预训练,然后调整模型在说唱歌曲与调整节拍上的性能,微调模型即用于最终的说唱产生。客观评估和主观评估的实验结果都证实了DeepRapper在生成押韵和节奏的说唱歌词方面的优势。

Rap 数据集

以前用于rap生成的作品(Potash 等人,2015年;Liang等人,2018年;Nikolov等人,2020年)通常使用只有歌词的说唱数据集,而不考虑节奏节拍信息。为了在rap生成中建模节奏,说唱数据集应该包含具有对齐节奏节拍的歌词。然而,节拍对齐很难实现,因为它们的注释需要专业音乐家来识别说唱歌曲中的重读音节。

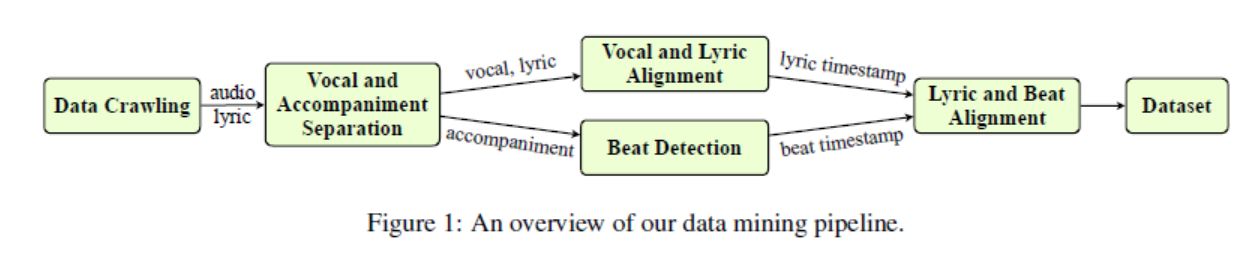

为了解决这个问题,研究者设计了一个数据挖掘pipeline来自动提取beatlyric对齐。

数据挖掘pipeline

图1展示了数据挖掘pipeline的整体框架,包含5个步骤:数据抓取、人声(vocal)与伴奏分离、人声与歌词对齐、节拍检测以及歌词与节拍对齐。

挖掘数据集

基于上图数据挖掘pipeline,研究者得到了一个具有对齐节拍的说唱歌词(rap lyric)数据集,并命名为D-RAP。该数据集满足了构建具有韵律和节奏的rap生成系统的要求。他们以4:1的比例将D-RAP数据集划分为训练和验证集。

与一般歌曲相比,说唱风格的歌曲数量往往较少,因此研究者挖掘了另外两个数据集,以使用相同的挖掘pipeline对DeepRapper模型进行预训练,它们分别是具有对齐节拍的非说唱歌曲数据集D-SONG和没有对齐节拍的纯歌词数据集D-LYRIC。

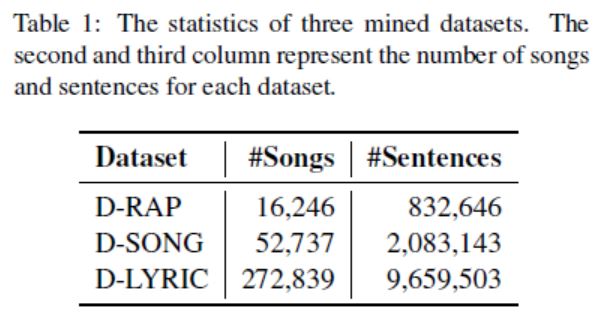

表1对这三个数据集包含的歌曲数量和歌词句子数量进行了统计。

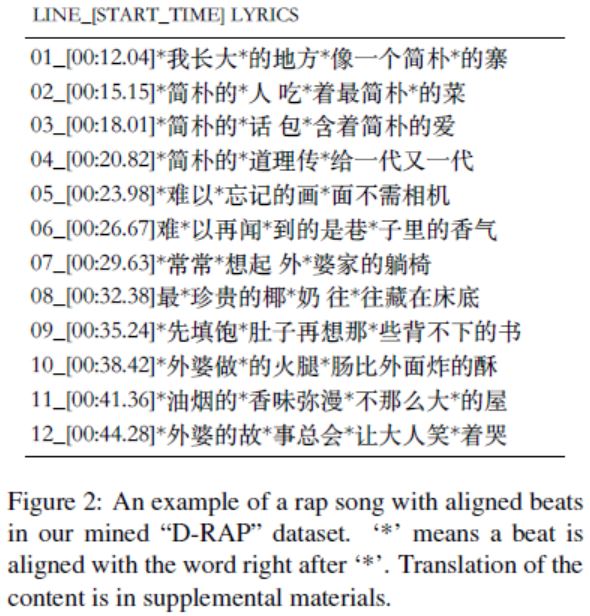

图2展示了D-RAP数据集中具有对齐节拍的说唱歌曲示例。

Rap生成模型

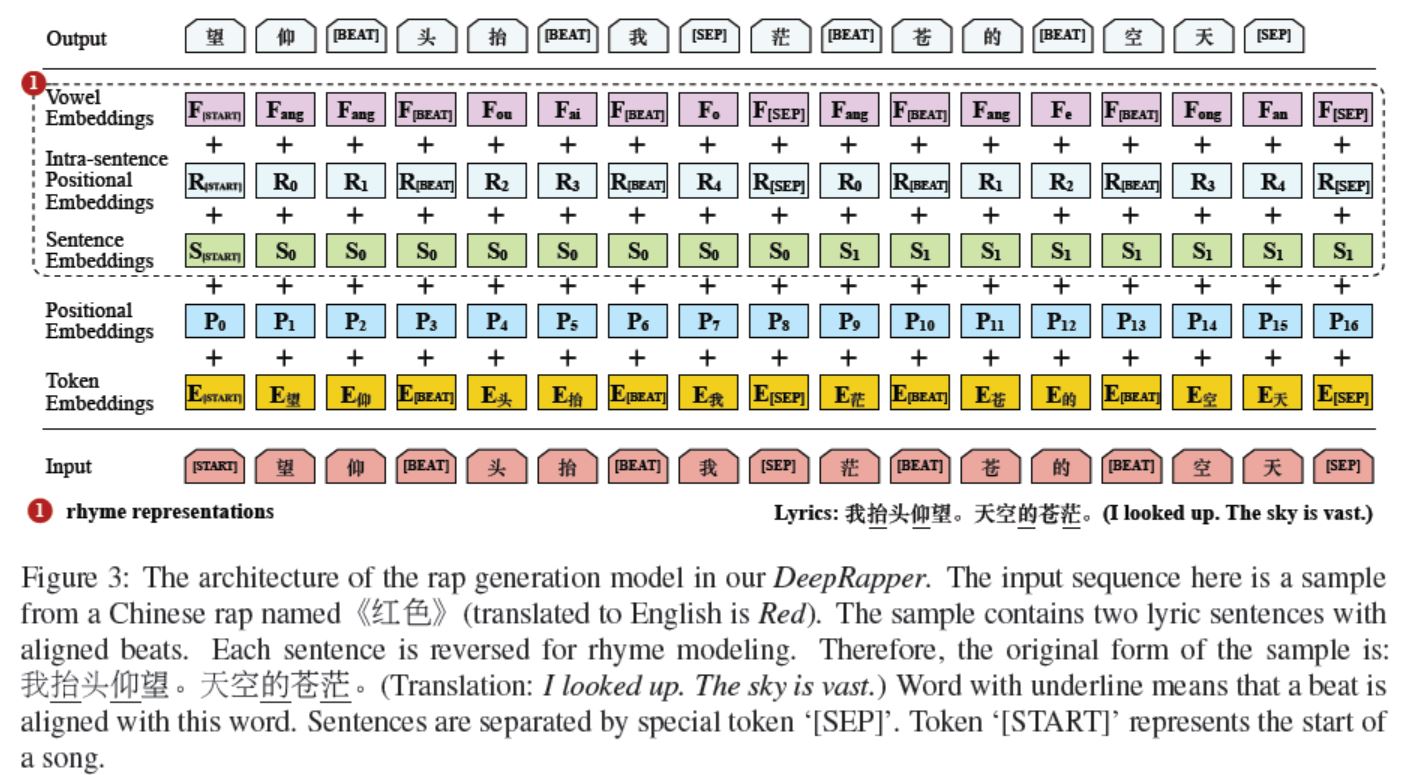

如图3所示,研究者展示了rap生成模型的整体架构以及韵律和节奏建模的细节。

具体地,研究者使用Transformer构建了一个用于rap生成的自回归语言模型,并引入了以下一些新的对齐:

(1)为了更好地建模韵律,该模型从左到右生成歌词句子,这是因为押韵字通常位于句子结尾;

(2)如前所述,节奏对于rap效果至关重要,因而插入了一个特殊的token [BEAT]来进行显式节拍建模;

(3)与仅有词嵌入和位置嵌入的原始Transformer不同,研究者添加了多个额外嵌入以更好地建模韵律和节奏。

实验评估

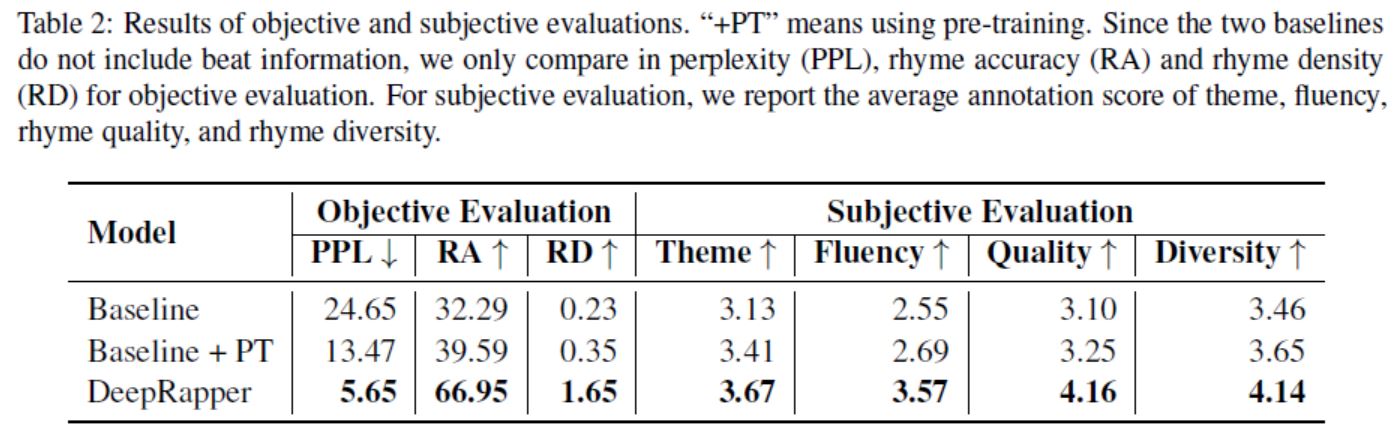

表2展示了DeepRapper的客观与主观评估结果,并与两个baseline进行了比较。Baseline模型是一个标准的自回归语言模型,与DeepRapper的模型配置相同,但没有本文提出的韵律模型(+PT的意思是采用了预训练)。客观评估结果的维度包括perplexity、韵律准确性和韵密度;主观评估维度包括主题、流畅度、押韵质量和押韵多样性。

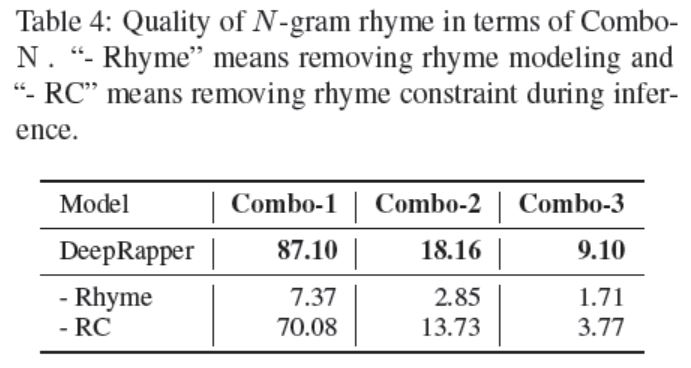

为了突出DeepRapper在建模N-gram韵律中的优势,研究者使用Combo-N来度量DeepRapper中每个设计建模N-gram韵律的能力。结果如下表4所示:

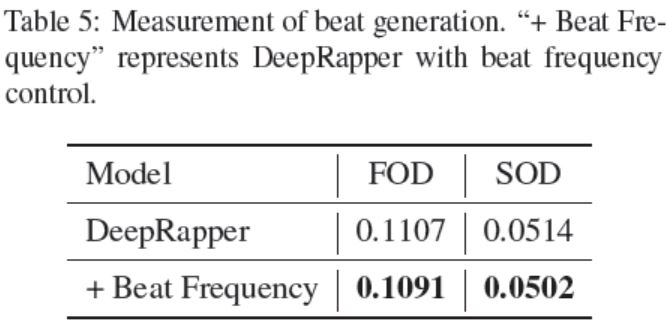

为了更好地度量节拍质量,研究者分别使用DeepRapper和具有节拍频率控制的DeepRapper随机生成了大约5000个样本。他们提出了一阶分布(First Order Distribution, FOD)和二阶分布(Second Order Distribution, SOD),并度量了生成样本与DRAP数据集之间分布的距离。

研究者将当前[BEAT]的间隔定义为当前[BEAT]与下个[BEAT]之间的歌词数量。因此,FOD被定义为当前[BEAT]间隔的分布,SOD被定义为当前[BEAT]与下个[BEAT]之间间隔差的分布。间隔的数值区间为[0, 1],具体结果如表5所示: