|

个人信息Personal Information

教师英文名称:Wei-Qiang Zhang

教师拼音名称:Zhang Wei Qiang

电子邮箱:

办公地点:电子工程馆5-111

联系方式:010-62781847

学位:博士学位

毕业院校:清华大学

学科:信号与信息处理

SpeechColab Leaderboard:一个开源的语音识别评测平台

点击次数:

过去十年间,随着深度学习浪潮的兴起,语音识别(ASR)技术也受到了广泛关注,出现了众多可公开使用的语音识别系统。然而由于各种原因,对这些ASR系统进行公正、一致可复现的性能评估仍具有挑战。在本文中,我们介绍了SpeechColab Leaderboard,这是一个为ASR评测而设计的通用开源平台。通过该平台:(i)我们报告了一系列基准测试,揭示了当前最先进的ASR系统的性能,其中涵盖了各种开源模型和商业服务。(ii)我们量化研究了测试流程中的一些处理细节会如何影响最终的测试结果。这些细微差别包括大小写、标点符号、插入语、缩略语、拼写变种、复合词的处理等。(iii)我们从Kolmogorov Complexity(柯尔莫哥洛夫复杂度)和Normalized Information Distance(NID)概念中汲取灵感,对传统的字/词级Token错误率(这里统称为Token Error Rate,TER)进行了改进,并称之为Modified Token Error Rate (mTER),该指标实现了适当的数值归一化,且相对reference和hypothesis具有对称性,是一种数学上更严谨优雅的测度。通过利用SpeechColab Leaderboard作为大规模测试平台,本文试图说明mTER与TER相比具有更好的鲁棒性,且基本兼容原有的TER指标。

代码链接:https://github.com/SpeechColab/Leaderboard

论文引用:J. Du, J. Li, G. Chen, and W.-Q. Zhang, “SpeechColab leaderboard: An open-source platform for automatic speech recognition evaluation,” Computer Speech & Language, vol. 94, Art. no. 101805, Nov. 2025. doi: 10.1016/j.csl.2025.101805.

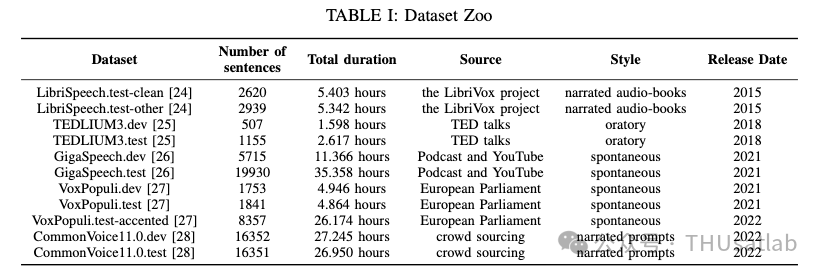

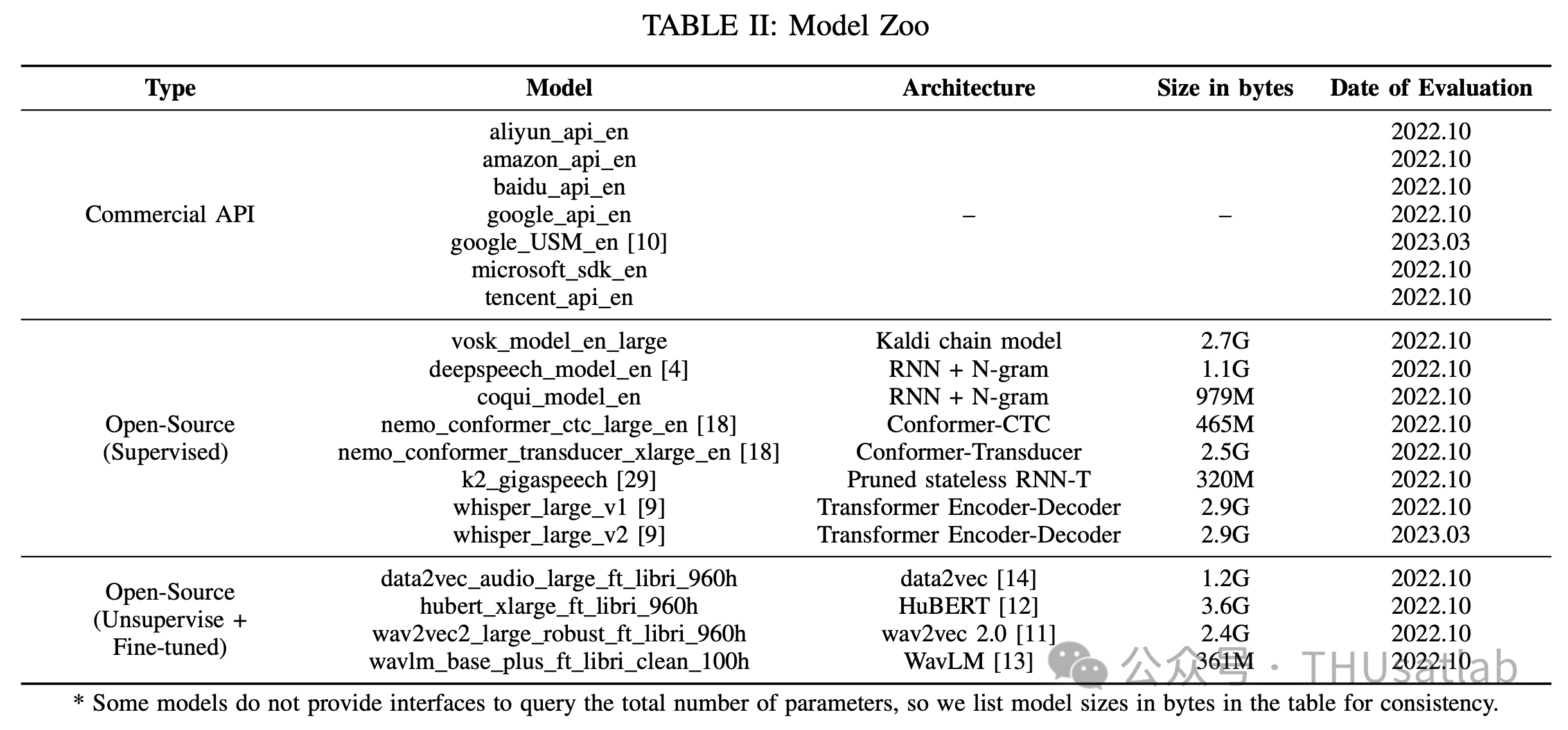

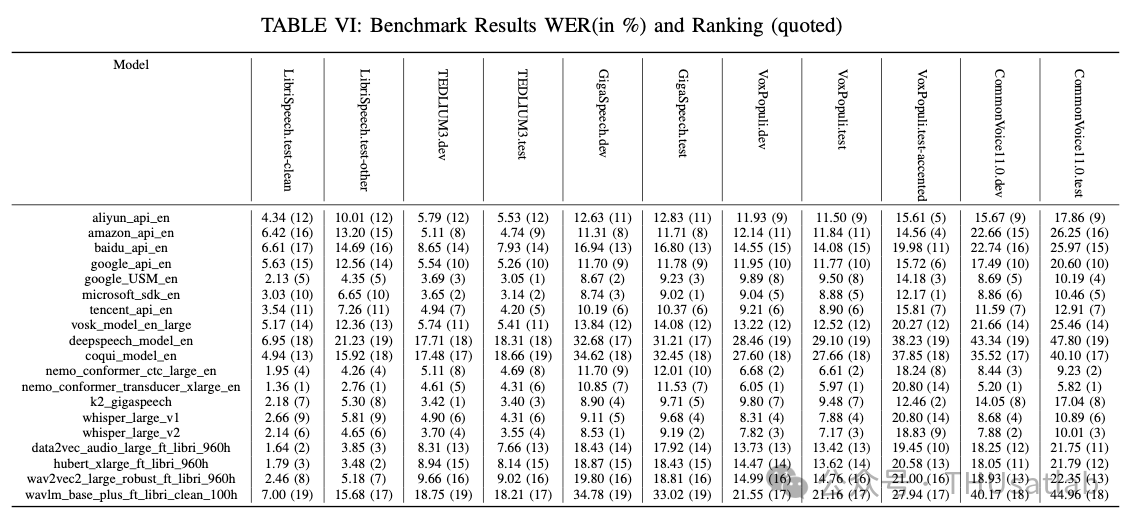

当前英文测试数据集与参与测试的语音识别模型信息如下表所示:

文本处理流程

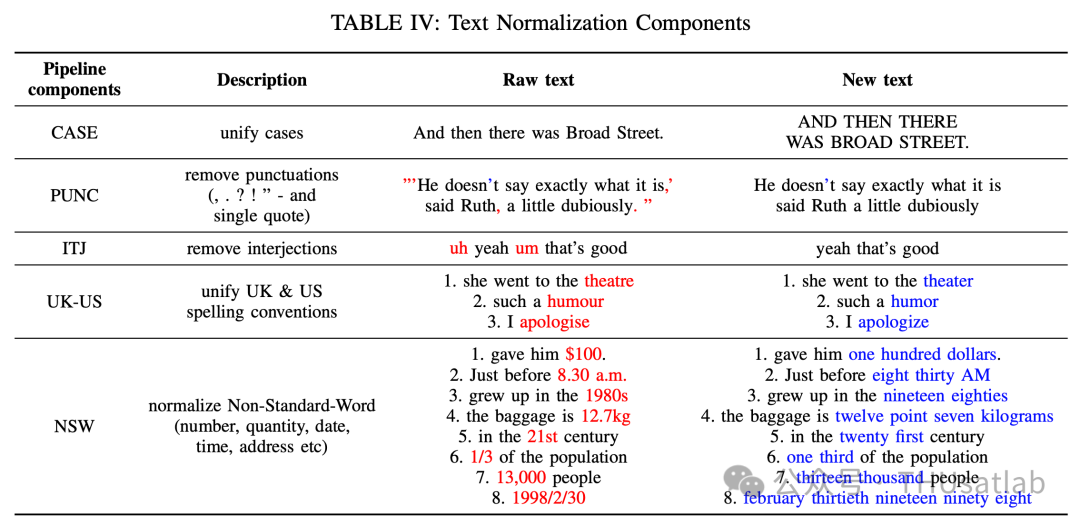

在实践中,参考标注(reference)和识别结果(hypothesis)往往具有不同的形式,因此需要进行文本预处理以消除差异,如下表所列,包括大小写、标点符号、常用插入语、美英拼写转换等问题。对于非标准词(NSW)的规范化,我们利用NeMo工具包中的上下文相关文法(Context-Dependent Rewriting Rules)对时间、日期、数字、货币等进行改写。

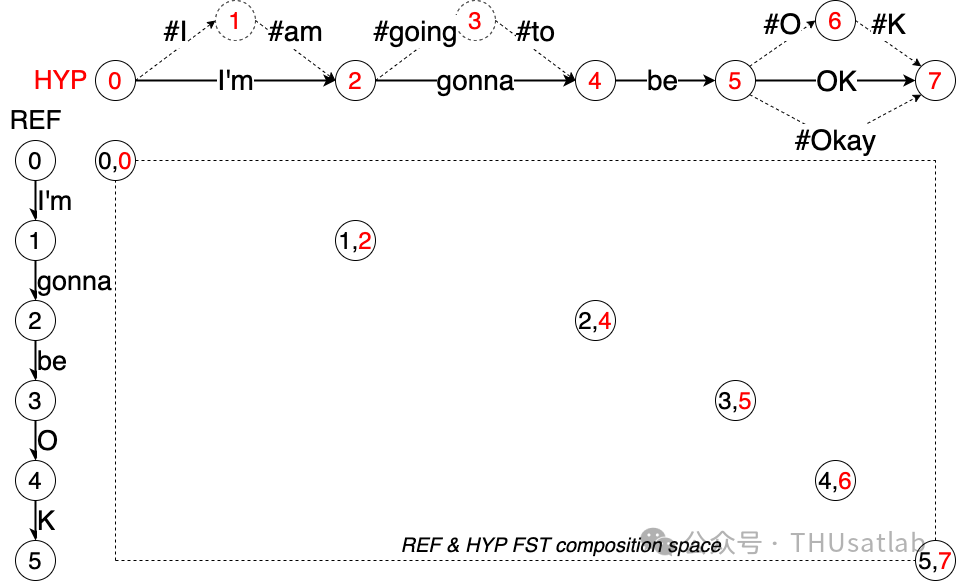

此外我们扩展了Levenshtein距离动态规划算法,支持了多条备选路径的匹配(DAE),用来处理缩略词、同义变形的复合词和短语等。如下图所示:

我们保持Ref的原始形式不变,而扩展后的Hyp则包含各种可能的变形(如上图中的虚线扩展部分所示)。这样一来,无论Ref中出现的人工标注为哪种具体形式,Hyp都能与之正确匹配。采用该方法而不是在文本规范化阶段直接处理,有两个原因:首先,从各种等价的形式中选取某一个具体的形式作为“官方”结果是有争议的,作为平台开发者,我们更倾向于提供一种灵活的机制,而不是制定一些武断的文本规范化策略。其次,该算法仅针对Hyp进行扩展,而始终尊重人类标注的原始形式(即Ref),在统计错误率时,分母的数值保持稳定,不会随DAE模块中的规则演变而发生改变。

测试结果

近十年来,语音识别技术发展迅速:OpenAI-Whisper模型与2014年的SOTA模型DeepSpeech相比,有了显著的WER降低:在 LibriSpeech 测试中,WER降低了78%;在TedLium3测试中,WER降低了81%;在GigaSpeech测试中,WER降低了71%;在VoxPopuli测试中,WER降低了75%;在VoxPopuli-accented测试中,WER降低了50%;在CommonVoice测试中,WER降低了79%。这些数字反映了语音识别技术在过去十年中取得的整体进步。

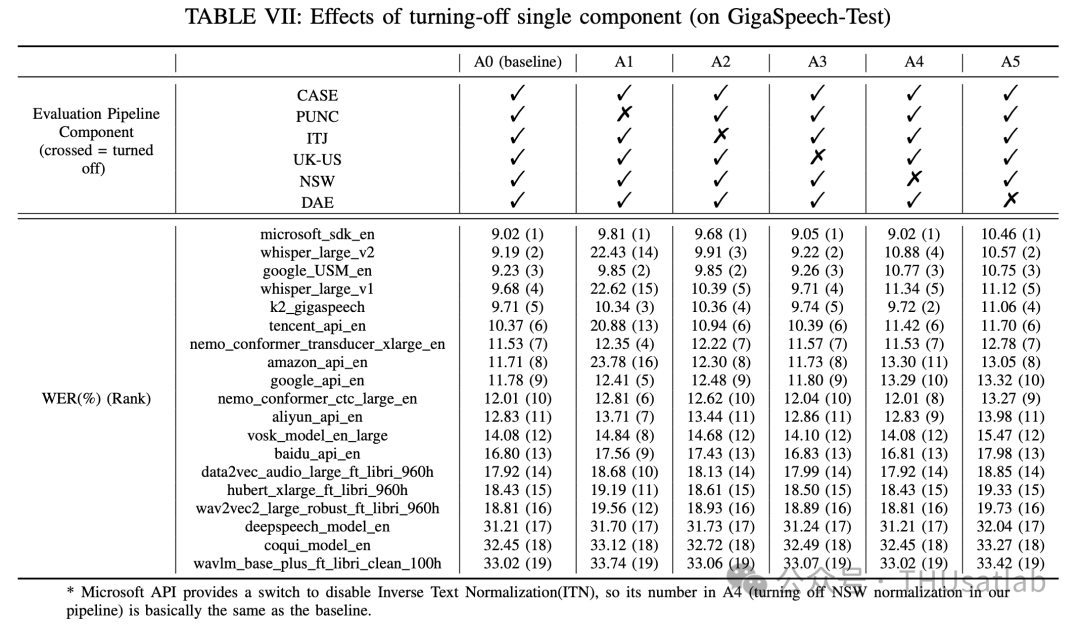

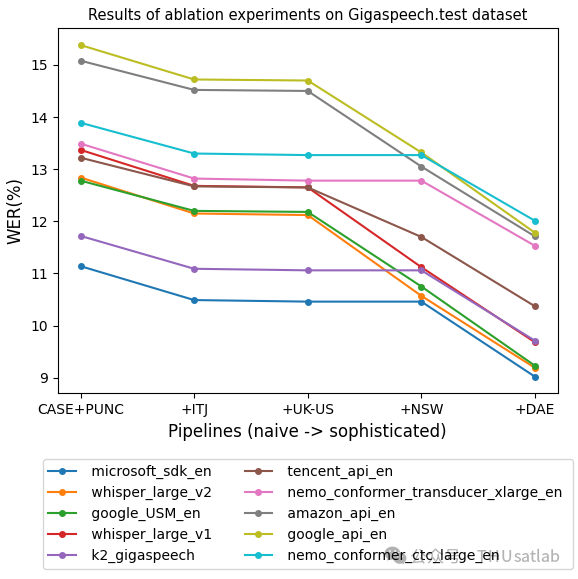

各个处理组件对结果的影响

评分流程中存在各种可能影响测试结果的组件,如标点符号、口语化的插入语、非标准单词规范化、美英拼写转换等。为了定量的了解这些细节的影响,我们进行了一组消融实验,如下表所示。

1)PUNC:A1和A0的对比提醒我们,标点符号的处理至关重要。若略去标点符号的处理,则整个评测就会完全被标点相关的错误主导。而标点符号的正确处理并非易事:因为常规的标点与缩略词中的单引号与撇号、数字中的逗号与点号、复合词中的连字符等混杂在一起。

2)ITJ:比较A2和A0,我们可以看到口语化的插入语会导致绝对WER变化约0.5%∼1.0%,相对WER增加了约10%。因此,在口语化的ASR任务的评测中,不能忽视插入语的处理,一般需仔细处理掉一系列常见的插入语,如 "uh"、"eh"、"um"等。

3)UK-US:比较A3和A0,我们可以发现统一英美拼写习惯的影响很小。

4)NSW和DAE:比较A4、A5和A0,可以看出NSW和DAE都至关重要。传统的学术ASR系统倾向于输出朗读形式的识别结果,而商业服务和现代端到端系统(如 Whisper)通常默认生成书面形式的结果,二者之间的差异显著。因此任何严肃的评测都应该确认这些细节,以确保统计错误率的文本形式是基本一致的。

在上图中,我们展示了上述各个因素是如何一步步叠加在一起的。从图中可以看出:(i)从最左侧(基于简单的测试处理流程)改进到最右侧(基于相对完善的测试处理流程),各个系统的性能排名可能发生改变。(ii)复杂的流程比原始流程相对减少20%-30%的WER。这些结果提出了一个令人担忧的启示,即系统的优劣和技术进步很容易被评测流程的实现细节所掩盖。因此,当讨论多个系统的错误率和排名时,应有意识地将所使用的具体工具包和流程纳入讨论范围,以避免造成误导。

对评估指标TER的修正

目前字/词错误率(统称为TER)存在的问题:

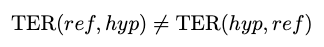

1)TER违反了度量空间公理:在数学中,一个度量空间需要满足一组被称为度量(不)等式的公理关系。而TER的定义不满足其中的对称性,即:

这在实践中有广泛的影响:工具需要实现非对称接口,对应的文档也需要格外强调插入(INS)与删除(DEL)的相对性。

2)TER的定义缺乏合理的数值归一化:TER采用|ref|作为归一化,这使得它在数值上没有上界。而作为一个相似性测度,错误率超过100%并不是一个直观的概念。

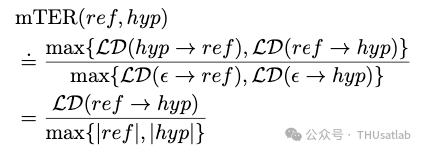

上述问题在之前的其它文献中也有被提及。在本文中,我们提出了一个简单实用的修改。它基于Kolmogorov Complexity和Normalized Information Distance(NID)的概念,定义如下(具体过程详见原文):

这里LD表示编辑距离。该指标修改了传统错误率统计的分母定义,由此得到的mTER不仅是对称的,而且是有界的([0% ~ 100%]),符合度量空间基本公理。

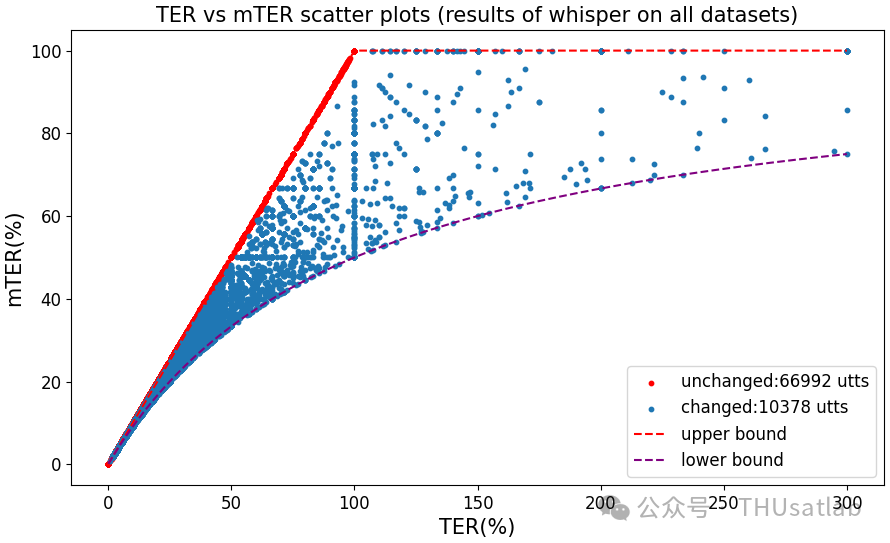

上图展示了whisper_large_v1模型测试中句子级的mTER与TER的对比。红色对角线上的样本代表mTER与TER完全一致的语句,占样本总数的 87%。其余13%的样本展示了mTER和TER的差异,以及mTER如何将TER数值溢出(即TER > 100%)修正到[0%, 100%]区间。而且我们发现,在进行测试集级别的性能评测时,新提出的mTER准确率与传统的TER指标基本兼容可比(详见原论文中的mTER与TER大规模对比)。

总结

本文介绍了自动语音识别的开源评估平台SpeechColab Leaderboard。基于该平台,我们开展并报告了广泛的基准测试,揭示了科研和工业领域最先进的自动语音识别系统的现状。此外,我们还对评估流程中不同组件的作用进行了定量研究,这为社区将来建立一系列ASR基准提供了有价值的参考。此外,通过利用我们的平台和基准结果,我们提出了一个新指标mTER,它比传统的错误率(TER)更鲁棒。未来,我们打算将更多数据集和模型纳入平台。