|

个人信息Personal Information

教师英文名称:Wei-Qiang Zhang

教师拼音名称:Zhang Wei Qiang

电子邮箱:

办公地点:电子工程馆5-111

联系方式:010-62781847

学位:博士学位

毕业院校:清华大学

学科:信号与信息处理

基于无监督预训练模型的零资源语音识别

点击次数:

本文介绍清华大学语音与音频技术实验室(SATLab)ISCSLP 2022录用论文Mutillingual Zero Resource Speech Recognition Based on Self-Supervised Pre-Trained Acoustic Models。这篇文章探索了语音无监督预训练模型的零资源学习能力,在完全不使用目标语种的语音数据的情况下为多个小语种构建了语音识别系统。在8个CommonVoice小语种上的测试结果表明,构建的零资源语音识别系统可以实现较低的平均词错误率。

H. Wang, W.-Q. Zhang, H. Suo, and Y. Wan, “Multilingual zero resource speech recognition base on self-supervise pre-trained acoustic models,” in Proc. ISCSLP, 2022, pp. 11–15. doi: 10.1109/ISCSLP57327.2022.10037938.

将预训练模型用于零资源ASR

准确的语音识别系统需要大量的有标注数据,但小语种的训练数据一般极难获得。无监督预训练模型能够利用大量的多语种、无标注数据,且其提取到的特征一般与音素高度相关,可以被视为一种语种间通用的音素级特征提取器。一些研究已经证明,无监督预训练模型在零资源音素识别任务中可以取得良好的效果。

我们尝试将无监督预训练模型应用到词级别零资源语音识别任务上,在不使用目标语种的语音数据,仅使用少量文本构建语言模型的情况下,为多种小语种构建了较为精准的语音识别系统。

解决方法

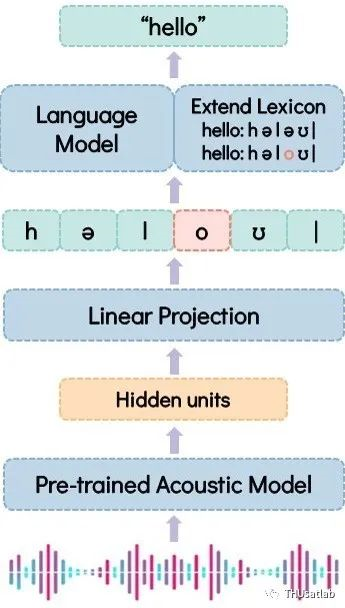

在声学模型部分,我们需要构建起预训练特征到音素的对应关系。我们使用了XLSR-53、Hubert Large和Data2vec Large三种不同结构的预训练模型,并将之在IPA音素识别任务上进行微调。

在语言模型部分,我们针对零资源识别任务进行了一些调整。首先是拆分词典中的双元音。我们注意到,目标语种中的集外音素多属于双元音和三元音,而组成它们的各个单元音则一般在训练集中都有出现,因此我们在词典和微调集文本中拆分了所有双元音和三元音。

除此之外,我们还对发音词典进行了扩展。我们观察到,零次音素识别结果中替代错误经常发生,因此如果发音词典能更为灵活,识别结果就可能有提高。我们使用已有的词典训练了一个G2P模型,并使用这个模型为词典中的每个词生成可能的发音变体。

我们将预训练模型在音素识别任务上进行微调,并通过拆分双元音、扩展词典等方式进一步适配零资源语音识别任务。

实验结果

我们使用10种语言构建了100小时的微调数据集,所有的标注文本都使用espeak-ng工具转为IPA音素。我们的测试集包括了8种Common Voice中的小语种数据。

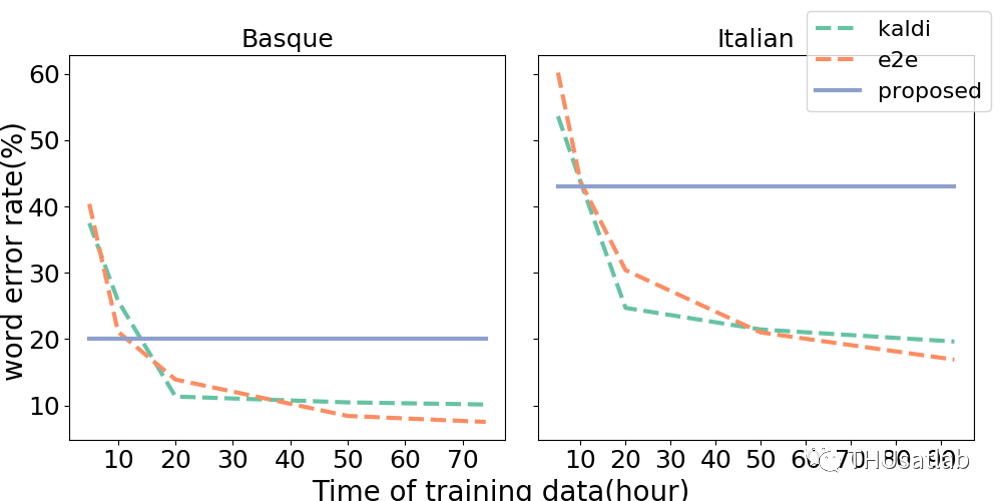

我们首先比较了提出的零资源方法与有监督训练在性能上的差距。我们在数据量较多的巴斯克语和意大利语进行比较,基线系统分别为Kaldi TDNN模型和ESPNet Conformer端到端模型。可以看出,我们的方法与使用10小时有监督数据训练的模型性能接近。

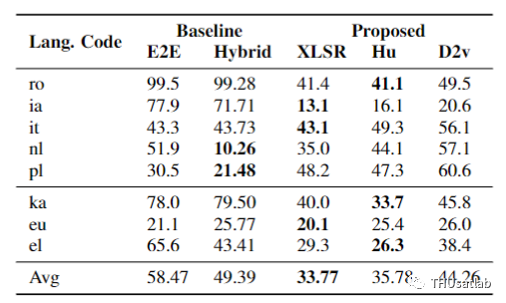

之后,我们在8种小语种上测试了提出方法的性能。这里基线模型使用不超过10小时有标注数据训练(对于希腊语、国际语、格鲁吉亚语和罗马尼亚语,训练集总数不到10小时,此时我们使用了全部训练数据)可以看出,在低资源情况下,我们提出的零资源方法普遍好于有标注模型。另外,我们的方法对微调语种和测试语种的相似度较不敏感。对于巴斯克语、希腊语和格鲁吉亚语,微调集中不含有属于同一语系的语种,但其识别错误率与测试集其他语种并无明显区别。

提出方法在8种测试语种上的词错误率(WER)(XLSR/Hu/D2v分别代表XLSR-53/Hubert Large/Data2vec Large模型)

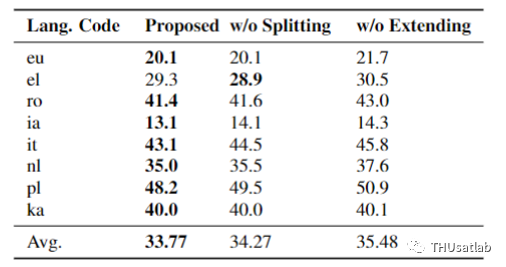

最后,一系列消融实验也证明切分双元音和扩展词典的有效性。

移除双元音切分和词典扩展后的性能表现(使用的预训练模型为XLSR-53)

结论

我们的方法将无监督预训练模型应用于零资源语音识别任务,在不使用目标语种的任何语音数据的情况下实现了平均33%的WER。在无训练数据或可获得的训练数据小于10小时的情况下,我们的零资源方法相比有监督方法有较大优势。